W opublikowanym w 2025 roku benchmarku OneRuler, język polski zajął pierwsze miejsce pod względem skuteczności w długich zadaniach kontekstowych dla dużych modeli językowych (LLM). Wyprzedził nawet angielski, który uplasował się dopiero na szóstym miejscu.

Dlaczego?

Polszczyzna, dzięki gramatycznej precyzji, złożonej fleksji i długim, bogatym semantycznie słowom, pozwala modelom upchnąć więcej treści w mniejszej liczbie tokenów. A to kluczowe, ponieważ każdy token to dodatkowy koszt obliczeniowy. W architekturze typu Transformer, która występuje w większości LLM-ów, sekwencja ma złożoność kwadratową.

W praktyce ten sam prompt po polsku może być tańszy, szybszy i bardziej precyzyjny niż jego odpowiednik po angielsku.

To jednak nie oznacza, że polski zawsze wygrywa.

Tokenizacja to tylko początek

Tak, język polski jest wyraźnie wydajniejszy w tokenizacji. Ale to tylko jeden z wielu czynników, które wpływają na jakość działania modelu. Co jeszcze się liczy?

1. Model

Architektura, sposób tokenizacji (czy tokenizer “czuje” polski), tryb reasoning, rozmiar i sposób trenowania (np. fine-tuning, Mixture of Experts) mają duże znaczenie.

2. Dane treningowe

Polski to język średnio-zasobny. Ma solidne korpusy, ale nie tak bogate jak angielski. Trudno ocenić, jak bardzo wyniki zależą od samego języka, a jak bardzo od danych treningowych, dopóki nie zostaną przetestowane inne konfiguracje.

3. Zastosowanie

Jeśli rynek pójdzie w stronę małych, wyspecjalizowanych modeli (SLM), które operują na krótkim kontekście i konkretnej dziedzinie (np. medycyna, prawo, kod), to przewaga wynikająca z wydajnej tokenizacji może mieć marginalne znaczenie.

Wnioski? To zależy

Nie warto popadać w euforię tylko dlatego, że „polski był pierwszy w benchmarku”. To ciekawy sygnał, ale nie ostateczny dowód na wyższość. Tokenizacja to tylko fragment układanki. Równie ważna jest architektura modelu, dostępność danych, długość kontekstu i konkretne zastosowanie.

Zamiast fetyszyzować rankingi, lepiej zajrzeć pod maskę i zrozumieć, dlaczego model działa tak, a nie inaczej.

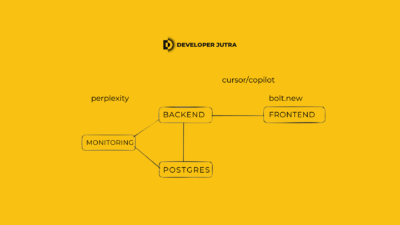

W Developerze Jutra Tomasz Ducin uczy pracy z LLM-ami tak, żeby nie tylko z nich korzystać, ale też rozumieć, co się za tym kryje.

Źródła:

- Repozytorium projektu OneRuler: https://github.com/mungg/OneRuler

- Opis benchmarku OneRuler (arXiv): https://arxiv.org/pdf/2503.01996

- Fragment lekcji z Modułu 1 Developer Jutra