PwC Data Analytics – zespół analizy predykcyjnej i Big Data (Analytics) oferuje m.in. usługi z zakresu analizy danych oraz modelowania zjawisk. Problemy klientów rozwiązuje nie tylko w oparciu o dane, ale też dogłębną znajomość rynku, wiodących trendów i szerokie doświadczenie. Realizuje projekty, dzięki którym klienci są w stanie wygenerować dodatkową wartość i wykorzystać potencjał w obszarach takich jak: m.in. elastyczność cenowa, przyporządkowanie klienta do nowej grupy, przychodowość i marżowość, skłonność do kupna oraz systemy rekomendacyjne.

Definicji Big Data, wraz ze wzrostem popularności tego terminu wśród menadżerów i firm na całym świecie, w różnego rodzaju publikacjach w ostatnich latach przybywało. Prawie tyle samo co danych, do których ten termin się odnosi. Oczywiście jest to spore wyolbrzymienie, jednak każdy, kto zetknął się z danymi lub interesował się tym tematem wie, że termin ten bywa nadinterpretowany. W szczycie popularności Big Data każda, nawet stosunkowo niewielka firma, była przekonana, że ta tematyka jej dotyczy. Dominowało przeświadczenie, że skuteczne ujarzmienie „gigantycznych” wolumenów danych jest kluczem do sukcesu w biznesie. Nikt nie zastanawiał się, czy wielkie wolumeny danych „social media”, lub „minuty w internecie”, mają istotne – czy jakiekolwiek – przełożenie na biznes (poza oczywistymi przykładami firm internetowych). W gruncie rzeczy, takie przekonanie jest jak najbardziej uzasadnione, ponieważ rozmiar, niezależnie od sposobu mierzenia i przedmiotu którego dotyczy, zawsze jest relatywny.

Big Data = wolumen + zróżnicowanie + szybkość przyrostu danych

Podstawowymi cechami świadczącymi o tym, że mamy do czynienia z Big Data, jest wolumen, zróżnicowanie i szybkość przyrostu danych. Natomiast granicę, od której możemy mówić o Big Data, dla poszczególnych cech wyznacza indywidualna zdolność firmy do pozyskania z nich adekwatnej informacji biznesowej. Dla jednej firmy będą to terabajty nieustrukturyzowanych danych pochodzących z internetu, na przykład serwisów społecznościach, forów internetowych. Dla innej: terabajty danych generowanych maszynowo, jak informacje zbierane podczas nawigacji użytkownika w bankowych serwisach internetowych, dane geolokalizacyjne generowane przez urządzenia mobilne czy dane paragonowe pochodzące z systemów POS. Dla jeszcze innej: dane socjo-demograficzne pochodzące ze stosunkowo niewielkiej bazy klientów. W ostatnim przypadku wyznacznikiem Big Data nie będzie wolumen danych ani ich struktura i dynamika przyrostu, a możliwości przetwarzania i szybkość podejmowanych decyzji biznesowych w oparciu o ich analizę.

PwC Data Analytics doskonale wie, że Big Data to nie tylko dane, ale też wszystko, co z nimi jest związane. Mamy tu na uwadze składowanie i przetwarzanie danych, czyszczenie i kontrolę jakości, zarządzanie, oraz to co najważniejsze: kompleksowy proces analityczny prowadzący do pozyskania z nich konkretnej informacji biznesowej. Dane traktujemy jako surowiec – nieprzetworzony – który jednak w dużym stopniu, poddany odpowiedniej obróbce, może posłużyć do podjęcia decyzji lub usprawnić proces biznesowy. Dzieje się tak dzięki stosowaniu różnych technik analizy danych w różnych momentach procesu ich przygotowania.

Prace analityczne nad danymi zaczynają się od standardowych raportów odpowiadających na pytanie: „co się stało?”. Na tym etapie analizy danych tworzone są statystyki, podsumowania i agregaty dotyczące poszczególnych wymiarów i miar, a także wykorzystywane są wykresy pozwalające na graficzną prezentację danych i odkrywanie w nich pewnych wzorców.

Etapy analizy danych: co się stało i dlaczego tak się stało?

Kolejnym etapem jest proces analizy danych z wykorzystaniem statystyk opisowych oraz mniej zaawanasowanych analiz statystycznych (np. analiza wariancji, regresja liniowa, drzewa decyzyjne). Umożliwia to odkrycie pewnych zależności i udzielenie odpowiedzi na pytanie: „dlaczego tak się stało?”

Końcowymi etapami procesu eksploracji danych (data mining) i pozyskania informacji i wiedzy biznesowej z danych jest modelowanie prognostyczne i predykcyjne. Zastosowanie technik modelowania szeregów czasowych, regresji, sieci neuronowych, klasteryzacji, analizy przeżycia pomaga określić zarówno w ujęciu czasowym (ciągłym) jak i pojedynczego zjawiska (dyskretnym) czego możemy się spodziewać w przyszłości. Pozwala to również przewidzieć z dużym prawdopodobieństwem dokładny końcowy efekt, czyli fakt zaistnienia badanego zjawiska.

Finalnym etapem analityki jest taka jej integracja ze środowiskiem decyzyjnym firmy, która podpowiada sposób działania w celu uniknięcia potencjalnych negatywnych skutków jakiegoś zjawiska. Jednym z przykładów może być uniknięcie utraty udziału rynkowego w obszarze pewnego segmentu/podsegmentu klientów. Inny przykład to wykorzystanie nadarzającej się okazji, która wiąże się z dużą skutecznością pewnych działań promocyjnych, wzrostem sprzedaży w na jakimś mikrorynku itd.

Przykłady:

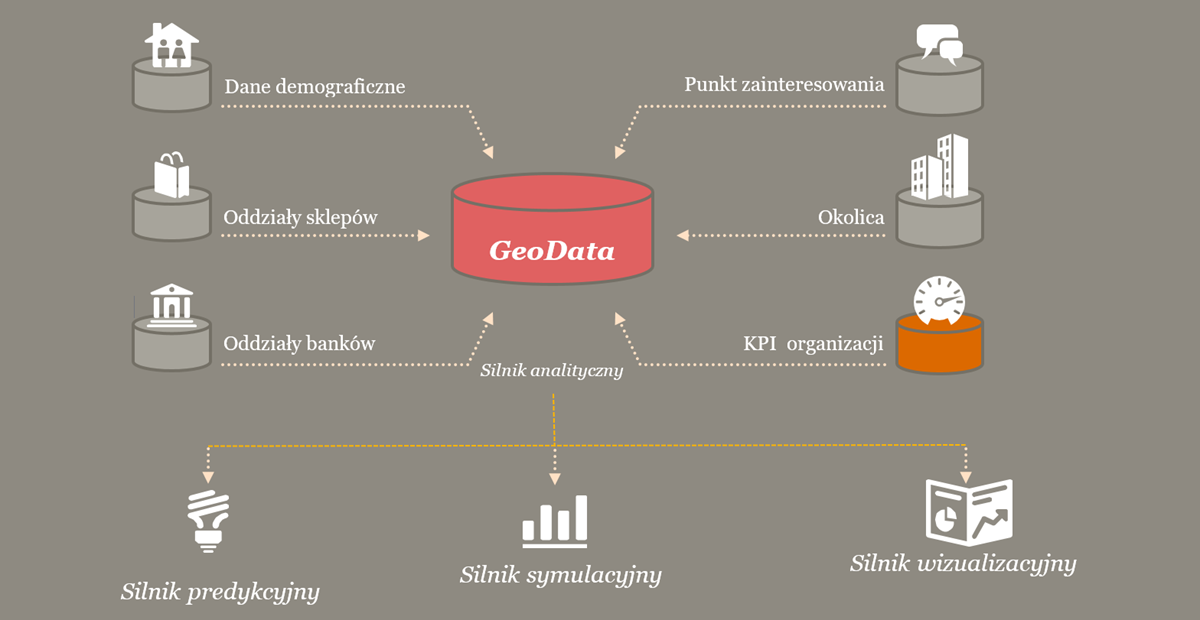

Podejście do danych: przykład Geo Data Mart

Wykorzystywane metody:

- Przetwarzanie w czasie rzeczywistym

- Data mining

- Analiza geoprzestrzenna

- Programowanie oparte o dane strumieniowe

Data Collector to narzędzie do pobierania danych z ogólnodostępnych zasobów Internetu – np. ze stron instytucji oraz organizacji (jak banki), Google Maps itp. Baza jest niemal codzienna aktualizowana bieżącymi informacjami o obiektach takich jak: markety, dyskonty, stacje benzynowe,

sklepy przemysłowe i odzieżowe, galerie.

Modelowanie

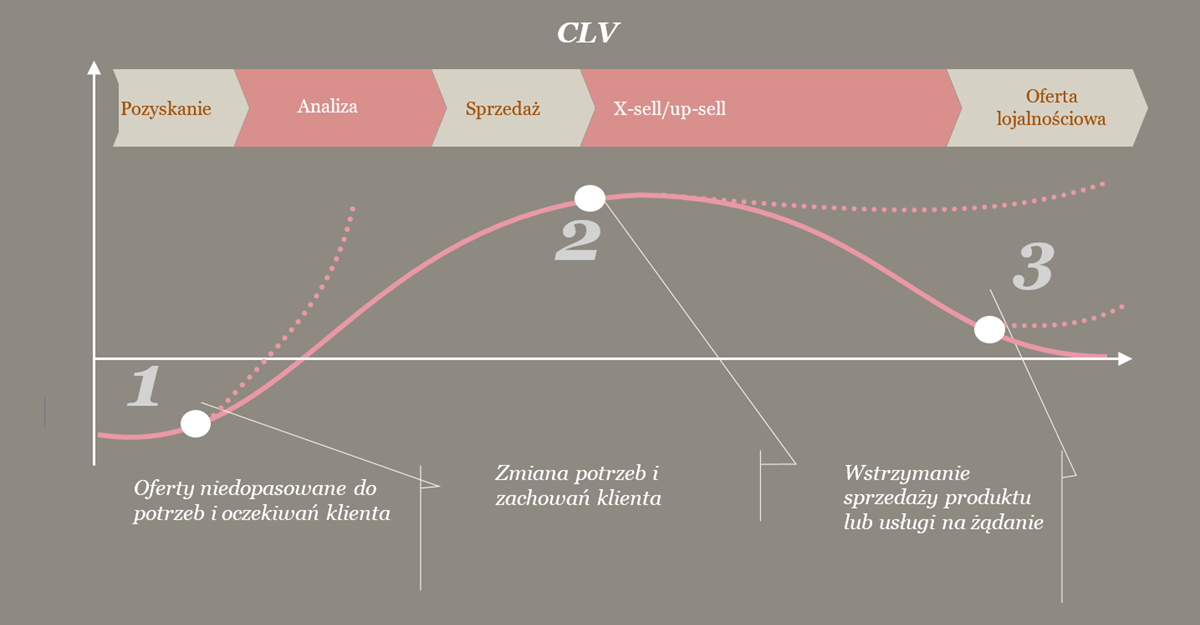

Przykład zarządzania cyklem życia klienta: x-sell, up-sell, churn, zwiększenie lojalności, kalkulacja wartości klienta w cyklu życia (CLV)

Wykorzystywane metody:

- Maszynowe uczenie

- Analiza geoprzestrzenna

- A/B testing

- Klastrowanie

- Real Time processing

- Wyodrębnianie tekstu, text mining

- Modele grafowe

Jednym z trendów sprzedaży detalicznej jest zmiana oczekiwań i zachowań zakupowych klientów. Współczesny konsument ma szeroki wybór produktów, marek, miejsc i może kupować co i gdzie chce. Dodatkowo szybki i nieograniczony dostęp do informacji poprzez urządzenia mobilne powoduje, że klient jest w stanie w ułamku sekundy sprawdzić ofertę firmy, porównać ją z ofertą konkurencji i zapoznać się z opiniami innych konsumentów. To wszystko sprawia, że mamy do czynienia z tzw. „smart consumer”. Ciekawe jest, czy wykorzystanie narzędzi marketing automation i prostych reguł, może być wykorzystane przez konsumentów przeciw samej firmie – np. promowanie urodzin etc..

Firmy, które chcą nadążyć za dynamicznym otoczeniem, powinny szczegółowo analizować zachowania swoich klientów i skutecznie zarządzać ich doświadczeniami zakupowymi. Oferty kierowane do klientów powinny być dopasowane do ich potrzeb (mass personalization), każda zmiana potrzeb i zachowań powinna być zauważona, a oferta ponownie dopasowana.

Satysfakcja klienta to jedno, a optymalizacja wydatków i zwiększenie zysków firmy to drugie. Kalkulacja wartości klienta w cyklu życia to działania marketingowe oparte na kalkulacji prognozowanych przychodów, które skutecznie wzmacniają przywiązanie do marki i produktu. To także optymalizacja wydatków na działania marketingowe i zapewnienie możliwości migracji klientów między kanałami, jak również możliwość oferowania produktów w odpowiednim momencie, co poprawia konwersję na sprzedaż produktów komplementarnych i produktów premium. Ponadto, oznacza to kierowanie działań promocyjnych do klientów, którzy są warci dla biznesu najwięcej (lub też mogą być warci najwięcej), a nie do całej bazy.

Prawdziwy model wartości klienta jest modelem predykcyjnym, który przewiduje, jak wiele przychodu klient może nam przynosić (nawet jeśli teraz nie jest go wiele), jak również rozpoznawanie zagrożeń, że klient jest pod zwiększonym ryzykiem zerwania relacji (tzw. „churn”) i uwzględnieniu tego w odpowiednim ofertowaniu. Dobry model wartości klienta może stać się wspólnym mianownikiem do wszelkich działań marketingu analitycznego. Dzieje się tak, ponieważ każde działanie zwiększające wartość klientów do których kierowana jest kampania, lub też zapobiegających jej spadkowi, może być mierzone w jeden spójny sposób, ułatwiający późniejsze raportowanie i podejmowanie decyzji marketingowych.

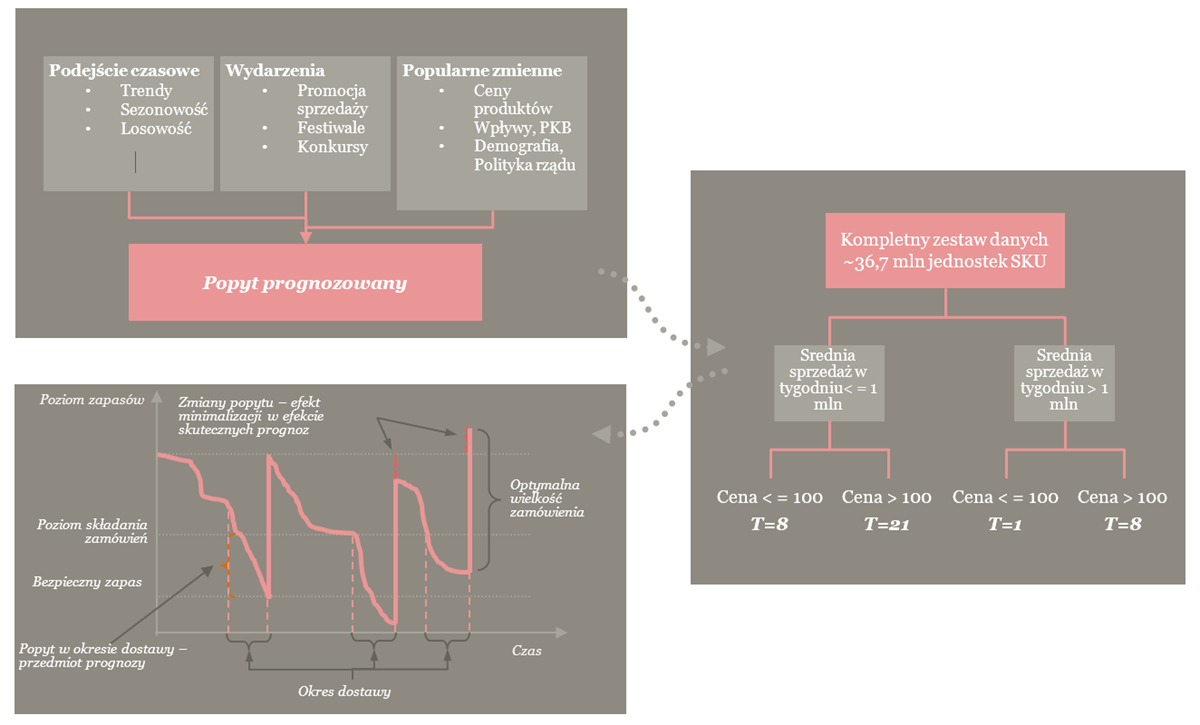

Modelowanie: Przykład optymalizacji poziomu zapasów oraz reedukacja braków sprzedażowych

Wykorzystywane metody:

- analiza szeregów czasowych

- czasowa regresja logistyczna

- przetwarzanie w czasie rzeczywistym

Analiza ma na celu identyfikację kluczowych czynników wpływających na popyt (trendy, sezonowość, promocje, ceny itp.) i przygotowanie prognozy popytu, następnie klasteryzację sprzedaży w oparciu o kluczowe cechy (tempo, sprzedaży, zmienność, marża) i w końcu optymalizację algorytmów i procesów uzupełniania zapasów poprzez symulacje (uwzględniające również ograniczenia np. wynikające z logistyki, lub cele jakościowe tj. dany poziom stock-outów i inne). Wynikiem analizy jest dokładne oszacowanie dla poszczególnych produktów czasu do następnej sprzedaży.